Почти каждый проект, который приходит к нам на аудит либо продвижение, имеет некорректный файл robots.txt, а часто он вовсе отсутствует. Так происходит, потому что при создании файла все руководствуются своей фантазией, а не правилами. Давайте разберем, как правильно составить этот файл, чтобы поисковые роботы эффективно с ним работали.

Зачем нужна настройка robots.txt?

Robots.txt — это файл, размещенный в корневом каталоге сайта, который сообщает роботам поисковых систем, к каким разделам и страницам сайта они могут получить доступ, а к каким нет.

Robots.txt — это файл, размещенный в корневом каталоге сайта, который сообщает роботам поисковых систем, к каким разделам и страницам сайта они могут получить доступ, а к каким нет.

-

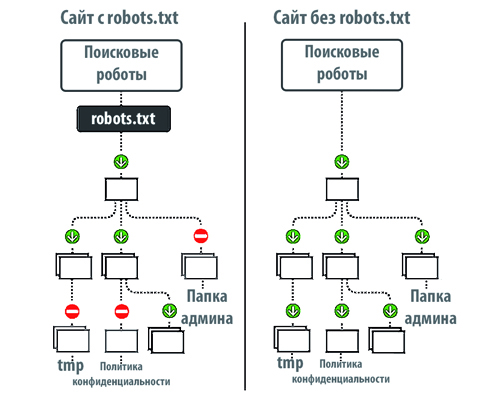

Поисковый робот будет считывать весь сайт, что «подорвет» краулинговый бюджет. Краулинговый бюджет — это число страниц, которые поисковый робот способен обойти за определенный промежуток времени.

Без файла robots, поисковик получит доступ к черновым и скрытым страницам, к сотням страниц, используемых для администрирования CMS. Он их проиндексирует, а когда дело дойдет до нужных страниц, на которых представлен непосредственный контент для посетителей, «закончится» краулинговый бюджет.

-

В индекс может попасть страница входа на сайт, другие ресурсы администратора, поэтому злоумышленник сможет легко их отследить и провести ddos атаку или взломать сайт.

Как поисковые роботы видят сайт с robots.txt и без него:

Синтаксис robots.txt

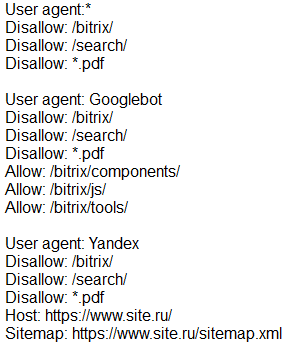

Прежде чем начать разбирать синтаксис и настраивать robots.txt, посмотрим на то, как должен выглядеть «идеальный файл»:

Но не стоит сразу же его применять. Для каждого сайта чаще всего необходимы свои настройки, так как у всех у нас разная структура сайта, разные CMS. Разберем каждую директиву по порядку.

User-agent

User-agent — определяет поискового робота, который обязан следовать описанным в файле инструкциям. Если необходимо обратиться сразу ко всем, то используется значок *. Также можно обратиться к определенному поисковому роботу. Например, Яндекс и Google:

Disallow

С помощью этой директивы, робот понимает какие файлы и папки индексировать запрещено. Если вы хотите, чтобы весь ваш сайт был открыт для индексации оставьте значение Disallow пустым. Чтобы скрыть весь контент на сайте после Disallow поставьте “/”.

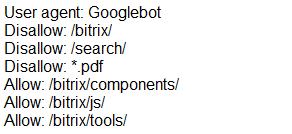

Мы можем запретить доступ к определенной папке, файлу или расширению файла. В нашем примере, мы обращаемся ко всем поисковым роботам, закрываем доступ к папке bitrix, search и расширению pdf.

Allow

Allow принудительно открывает для индексирования страницы и разделы сайта. На примере выше мы обращаемся к поисковому роботу Google, закрываем доступ к папке bitrix, search и расширению pdf. Но в папке bitrix мы принудительно открываем 3 папки для индексирования: components, js, tools.

Host — зеркало сайта

Зеркало сайта — это дубликат основного сайта. Зеркала используются для самых разных целей: смена адреса, безопасность, снижение нагрузки на сервер и т. д.

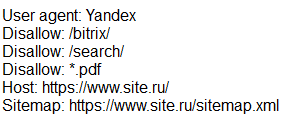

Host — одно из самых важных правил. Если прописано данное правило, то робот поймет, какое из зеркал сайта стоит учитывать для индексации. Данная директива необходима для роботов Яндекса и Mail.ru. Другие роботы это правило будут игнорировать. Host прописывается только один раз!

Для протоколов «https://» и «http://», синтаксис в файле robots.txt будет разный.

![]()

Sitemap — карта сайта

Карта сайта — это форма навигации по сайту, которая используется для информирования поисковых систем о новых страницах. С помощью директивы sitemap, мы «насильно» показываем роботу, где расположена карта.

Символы в robots.txt

Символы, применяемые в файле: «/, *, $, #».

- Слэш «/», скрывает от обнаружения различные страницы сайта.

- Звездочка «*» применяется для обозначения любой последовательности символов в файле.

- Знак доллара «$» сдерживает действия знака звездочки. С помощью него, можно запретить содержимое папки, но адрес который содержит папка, разрешить.

- Решетка «#» применяется для комментирования. Робот не учитывает эти записи при сканировании сайта.

Проверка работоспособности после настройки robots.txt

После того как вы разместили Robots.txt на своем сайте, вам необходимо добавить и проверить его в вебмастере Яндекса и Google.

Проверка Яндекса:

- Перейдите по ссылке.

- Выберите: Настройка индексирования — Анализ robots.txt.

Проверка Google:

- Перейдите по ссылке.

- Выберите: Сканирование — Инструмент проверки файла robots.txt.

Таким образом вы сможете проверить свой robots.txt на ошибки и внести необходимые настройки, если потребуется.

В заключение приведу 6 главных рекомендаций по работе с файлом Robots.txt:

- Содержимое файла необходимо писать прописными буквами.

- В директиве Disallow нужно указывать только один файл или директорию.

- Строка «User-agent» не должна быть пустой.

- User-agent всегда должна идти перед Disallow.

- Не стоит забывать прописывать слэш, если нужно запретить индексацию директории.

- Перед загрузкой файла на сервер, обязательно нужно проверить его на наличие синтаксических и орфографических ошибок.

Успехов вам!

Видеообзор 3 методов создания и настройки файла Robots.txt

-

Хотите, чтобы ваш сайт реально продавал? Готовы работать вместе с нами? Оформите заявку