В этой статье я помогу вам разобраться в том, какие страницы не стоит индексировать, как удалить страницы из индекса поисковиков и зачем это нужно делать.

Содержание:

-

Зачем нужно удалять страницы из индекса и что это за страницы

-

Показатель отказов.

-

Глубина просмотра (среднее количество просмотренных страниц в рамках одной сессии).

-

Время, проведенное пользователем на странице.

-

Среднее время, проведенное пользователем на сайте.

-

Поведение пользователей на выдаче.

-

Страницы с GET-параметрами, которые выступают дублями посадочных страниц (страницы сортировок или с различными вариантами отображения карточек товаров и т. д.). Примеры таких страниц: https://site.ru/catalog/page1/?sort=sort&order=asc; https://site.ru/catalog/page2/?display=list.

-

Страницы с результатами поиска по сайту, страницы сравнения (https://site.ru/search/?q=&s=Найти; https://site.ru/catalog/page1/compare.php).

-

Страницы с неуникальным контентом.

-

Страницы, не несущие в себе смысловой нагрузки (административные и технические страницы с персональной информацией).

-

Системные каталоги и файлы.

-

Страницы, удаленные на сайте, но все еще отображающиеся в поиске.

-

Необходимо удалять из индекса страницы, по которым не притягивается трафик из поиска.

-

Удаление ненужных страниц дает улучшение релевантности сайта и поведенческих факторов на выдаче.

-

Ключевые методы удаления страниц из индекса:

-

Директива Disallow в Robots.txt.

-

Настройка HTTP-кодов ответа от сервера 404, 403 и 410.

-

Директива noindex, используемая в HTTP-ответе страницы и метатеге.

-

Самые результативные способы удаления страниц из индекса – это настройка 404, 403 и 410 HTTP-кодов ответа сервера и директива noindex, используемая в HTTP-заголовке, либо коде страницы.

-

Директива Disallow не дает 100%-ой гарантии, что страница не будет снова занесена в индекс. А страница, защищенная паролем, в свою очередь создаст неудобства для пользователей.

Зачем нужно удалять страницы из индекса и что это за страницы?

«Ненужные страницы» – это страницы, которые не предназначены для притягивания трафика из поиска и их дальнейшего продвижения.

Устранение подобных страниц из индекса позволяет удалить лишние копии страниц, скрыть персональную информацию и, самое главное, улучшить хостовые поведенческие факторы, которые включают в себя такие основные показатели, как:

Логика простая: чем больше мусорных страниц в поиске, по которым не кликают, тем хуже значения хостовых поведенческих факторов сайта, что влечет за собой ухудшение ранжирования.

К таким страницам относятся:

Как удалить страницы из поисковой выдачи?

Рассмотрим ключевые методы удаления страниц из индекса.

1 способ. Директива Disallow в файле Robots.txt

Используя данную директиву, можно дать указания роботу не посещать список заданных страниц.

Имеется существенное дополнение.

Страница, запрещенная к индексированию с помощью директивы Disallow, все равно может быть просканирована и проиндексирована. Что может происходить из-за того, что на настоящую страницу ссылаются иные страницы на сайте.

Стоит отметить и то, что Yandex чаще всего воспринимает директивы robots.txt как четкие инструкции по внесению в индекс. Совсем другая ситуация с «Гуглом», для него robots.txt – это всего лишь рекомендации. Поэтому, если вы закрыли страницу от индексации в robots.txt, поисковые роботы Google все равно могут ее проиндексировать. Чтобы этого избежать, можно воспользоваться другими способами, описанными ниже.

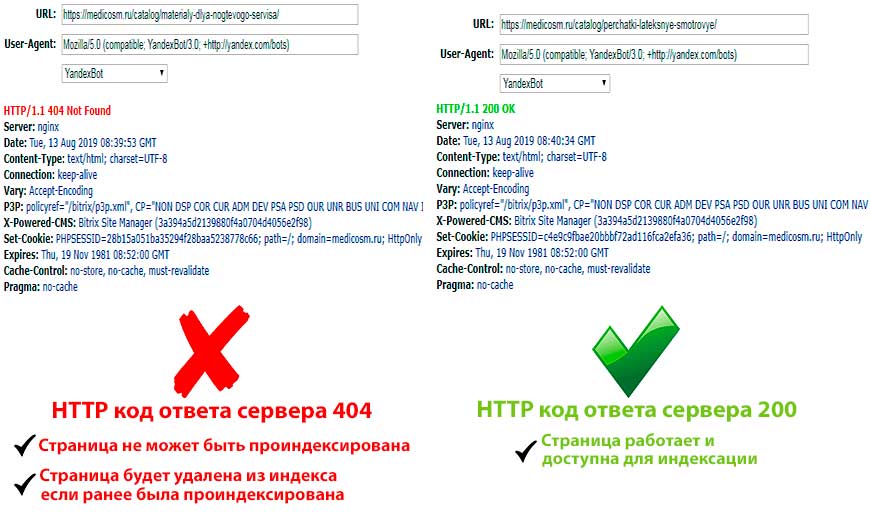

2 способ. Настройка 404, 403 и 410 HTTP-кодов ответа от сервера

При получении одного из этих кодов ответа при посещении страницы, робот воспринимает ее более недоступной и исключает ее из индекса.

Работающая страница, которая подлежит индексации, должна отдавать код 200.

Проверить HTTP-коды ответа сервера можно с помощью сервиса bertal.ru

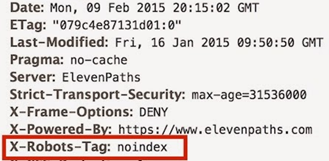

3 способ. Директива noindex в HTTP-ответе сервера

Мы уже выяснили, что робот при обходе страницы получает какой-либо ответ с сервера в котором содержатся специальные коды. Они показывают роботу, что сканируемая страница работает, либо недоступна. Но может возникнуть ситуация, когда страница должна работать на сайте, т. е. отдавать код 200, но ее нельзя индексировать. При таких условиях в HTTP-ответ сервера можно добавить HTTP-заголовок, который будет запрещать индексирование данной страницы.

HTTP-заголовок для запрета к индексации выглядит так:

X-Robots-Tag: noindex

Образец кода ответа сервера с применением noindex:

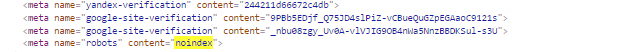

4 способ. Директива noindex, прописанная в метатеге

Задается в коде страницы при помощи тега <meta name=”robots” content=”noindex”>

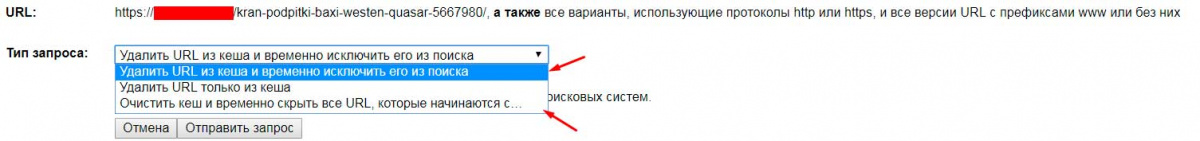

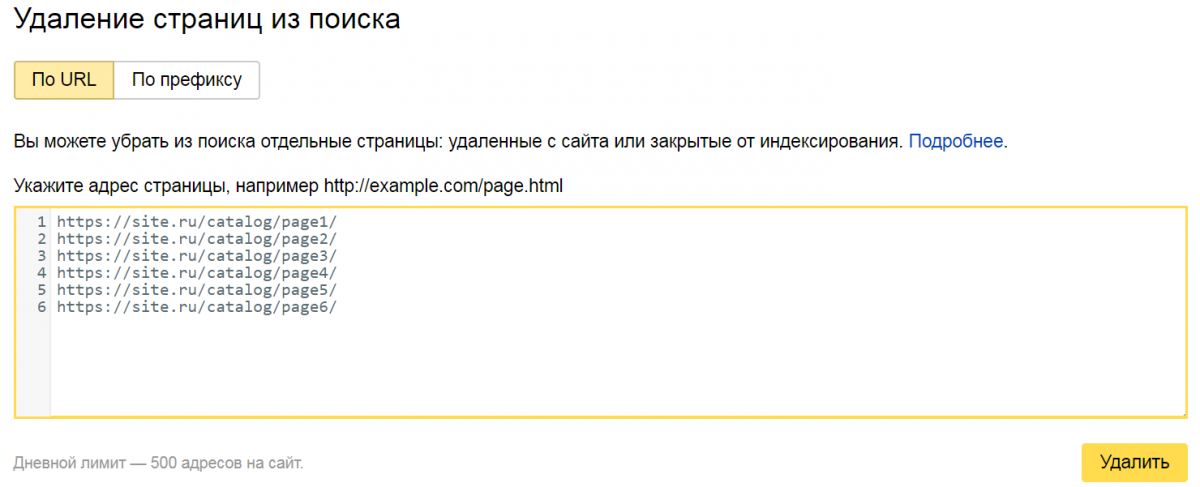

5 способ. Устранение страниц из поиска в сервисе «Яндекс Вебмастер»

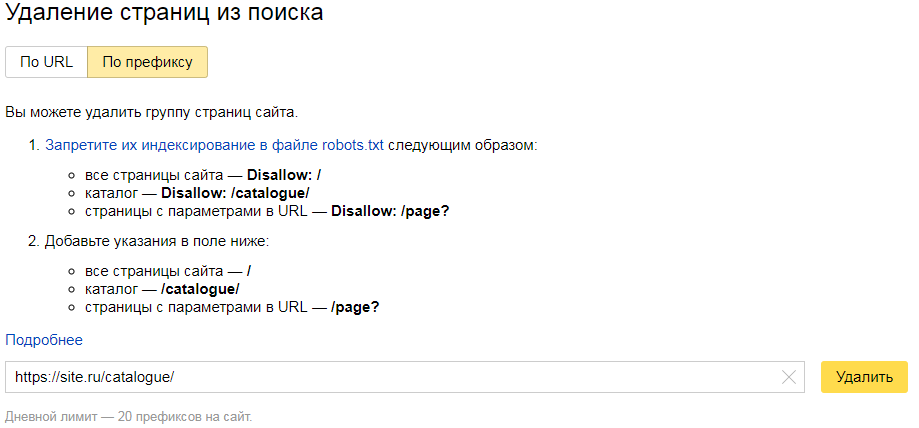

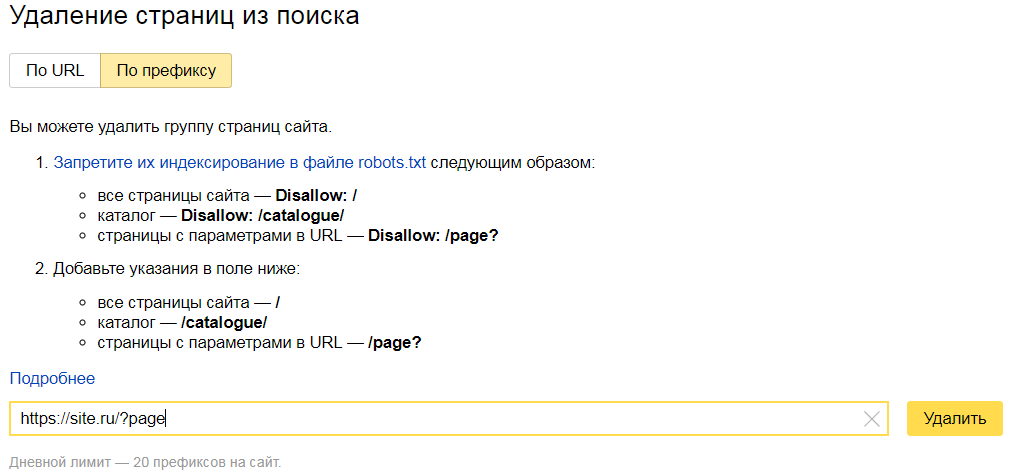

«Яндекс Вебмастер» предлагает 2 способа исключения страниц: по URL и по префиксу.

Используя вариант удаление «по URL», в окне сервиса необходимо просто указать список страниц, которые вам необходимо удалить.

Удаление «по префиксу» позволяет устранить все страницы, вложенные в каком-либо разделе или страницы, содержащие определенный параметр.

Например на сайте https://site.ru необходимо удалить все страницы из раздела catalogue, для этого в «Яндекс Вебмастере» откроем вкладку по префиксу и укажем УРЛ https://site.ru/catalogue/. В итоге все страницы из раздела catalogue будут удалены из индекса.

Если нужно удалить все страницы, которые содержат параметр после символа «?» в адресе, воспользуемся такой записью:

Перед тем, как отправить страницы на удаление в «Яндекс Вебмастере», необходимо запретить соответствующие страницы к индексации в robots.txt, иначе ваша заявка на удаление страниц будет отклонена.

6 способ. Удаление страниц из поиска в сервисе Google Search Console

Инструмент Google URL Removal работает также, как и аналогичный инструмент в «Яндекс Вебмастер» и имеет возможность удалять страницы как по URL-адресу, так и по префиксу.

Основное отличие состоит в том, что с помощью данного инструмента Google исключает страницу из поиска временно (на срок до 90 дней). Иными словами через некоторое время отправленная на удаление страница, снова рискует попасть в индекс, если ее HTTP-код отличен от 404, 403, 410, и она не имеет установленной директивы noindex в коде страницы, либо в HTTP-заголовке.

7 способ. Защита страницы паролем

Разделы, защищенные паролем, запрещают поисковикам получить доступ к контенту, вследствие чего подобные страницы чаще всего не попадают в индекс.

Выводы

-

Ну а если у вас возникли трудности или вы не хотите тратить время, то можете заказать бесплатную SEO-консультацию у наших специалистов.